随着互联网的飞速发展,数据成为了公司和个人进行决策的重要依据。然而,如何获取大量的数据成为了一个挑战,手动获取数据效率低下,而且还容易出错。Python爬虫技术的出现解决了这个问题,它可以自动采集目标网站上的信息,并将数据整理成结构化的格式,提供给我们进行更深层次的分析和挖掘。

文章

一、Python爬虫简介

Python爬虫是指利用Python语言编写程序,模拟浏览器行为来抓取互联网上的数据。它主要包括网络请求、HTML解析和数据存储等三部分。网络请求是获取网页内容的第一步,HTML解析是将网页内容转化为程序可读的数据结构,数据存储是将获取到的数据保存到本地或者数据库中。

二、安装Python环境

在学习Python爬虫之前,我们首先需要安装Python环境。可以通过官网下载最新版的Python安装包,然后按照安装向导进行安装即可。

三、安装爬虫库

Python爬虫需要使用第三方库,包括网络请求库(requests)、HTML解析库(BeautifulSoup4)和数据存储库(pymysql等)。可以通过pip命令来安装这些库,具体命令可以参考官方文档。

四、爬虫实战:获取百度热搜榜

通过获取百度热搜榜,我们可以熟悉Python爬虫的基本操作。具体实现步骤包括发送网络请求、解析HTML页面、提取数据和数据存储等。

五、网页解析技巧

在进行网页解析时,我们需要掌握一些技巧,比如CSS选择器、XPath表达式和正则表达式等。这些技巧可以帮助我们更快速地定位到目标数据,并提高代码的可读性和可维护性。

六、动态网页爬取

对于一些动态网页,我们需要模拟浏览器行为来获取数据。这时可以使用Selenium等工具来模拟浏览器的操作,然后再进行页面解析和数据提取。

七、反爬虫技术

为了防止爬虫程序获取网站数据,有些网站会采用反爬虫技术。我们需要掌握一些反爬虫技术,比如使用代理IP、设置请求头等,来绕过网站的反爬虫机制。

八、自动化爬虫任务

对于一些需要定期获取数据的任务,我们可以编写脚本来实现自动化爬虫任务。这样可以节省大量的时间和人力成本,并且减少了人为出错的可能性。

九、数据存储技术

获取到数据后,我们需要将数据保存到本地或者数据库中。常用的数据库包括MySQL、MongoDB等。我们需要掌握相应的数据库操作技巧,来实现数据的存储和管理。

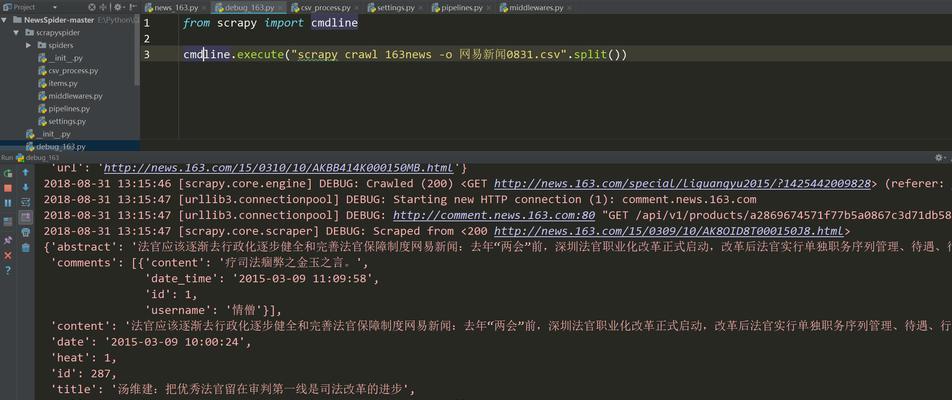

十、使用Scrapy框架开发爬虫

Scrapy是一个高级的Python爬虫框架,它包括了数据采集、数据处理和数据存储三个部分。使用Scrapy框架可以大大提高爬虫程序的效率和可维护性。

十一、爬虫程序优化技巧

在编写爬虫程序时,我们需要考虑程序的效率和可维护性。可以通过多线程、异步IO和分布式爬虫等技术来优化爬虫程序,提高数据采集和处理的效率。

十二、爬虫案例:天猫商品信息爬取

通过实现天猫商品信息的爬取,我们可以加深对Python爬虫的理解和掌握。具体实现步骤包括模拟登录、页面解析和数据提取等。

十三、数据处理技巧

获取到数据后,我们需要进行数据清洗和预处理,以便于后续的数据分析和挖掘。常用的数据处理技巧包括数据格式化、数据过滤、数据聚合等。

十四、数据可视化技术

数据可视化是将数据通过图表、地图等形式展示出来,方便我们更直观地观察数据。常用的数据可视化工具包括matplotlib、Seaborn等。

十五、

学习Python爬虫不仅可以提高我们的技能水平,还可以帮助我们更好地处理和分析大量的数据。通过阅读本文,相信大家已经对Python爬虫有了更深入的了解。在实践中不断摸索和学习,相信你也可以成为一名Python爬虫专家。